twg2020 发布的文章

儿歌1

001_数鸭子

002_两只老虎

003_小兔子乖乖

004_小手拍拍

005_拔萝卜

006_小燕子

007_采蘑菇的小姑娘

008_卖报歌

009_小螺号

010_一只哈巴狗

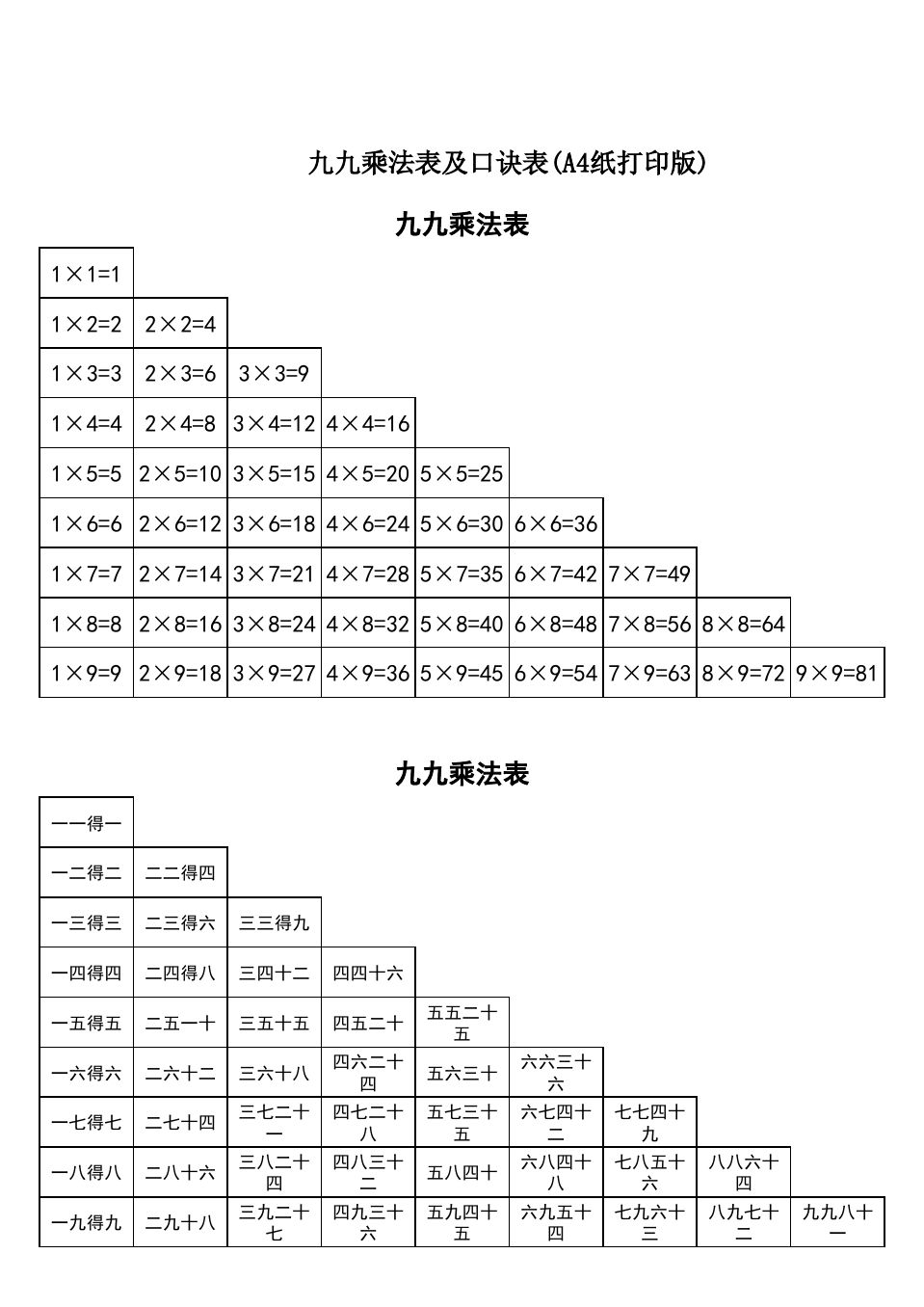

九九乘法表打印版

此内容被密码保护

Transformer模型中的Embedding和位置向量为什么是相加的关系

Transformer模型中的Embedding和位置向量直接相加是一种设计选择,这种操作在数学上是有理论依据的,并不会丢失信息。以下是一些原因解释为什么这样做是有效的:

- 线性变换的不变性:在神经网络中,线性变换(如矩阵乘法或向量加法)不会丢失信息,因为它们是可逆的。只要权重矩阵是满秩的,就可以通过逆矩阵变换恢复原始信息。因此,将Embedding和位置向量相加,实际上是另一种形式的线性组合,可以保持信息的完整性。

- 位置信息的加性:位置向量是为了给模型提供输入序列中各个元素的位置信息。这些向量通常是固定的,并且与词汇Embedding的维度相同。通过相加,位置向量可以直接作用于词汇Embedding的每个维度,提供位置信息的同时不会引入额外的维度,简化了模型结构。

- 量纲问题:确实,Embedding和位置向量的量纲可能不同,但是在实践中,这些向量在训练过程中会被学习到的权重所调整,使得它们能够在相加后共同作用于模型的后续计算。此外,神经网络的训练过程会自动调整这些权重,使得模型能够从数据中学习到有用的信息。

- 计算效率:将向量相加比将它们拼接起来更高效,因为它不会增加向量的维度。在处理长序列时,这可以显著减少模型的参数数量和计算复杂度。

总的来说,虽然将Embedding和位置向量直接相加是一种简化的假设,但在实践中,这种操作已经被证明是有效的,并且Transformer模型在各种NLP任务中都取得了出色的表现。当然,这也并不意味着相加是处理位置信息的唯一或最佳方式,不同的模型可能会采用不同的方法来融合词汇和位置信息。